文中摘自微信公众平台「Java极克技术性」,创作者鸭血粉丝。转截文中请联络Java极克技术性微信公众号。

自打阿粉经历过之前的大数据黑公关事情以后,显著觉得如今的服务平台针对客户十分的不友善呀,如果你高频率的检索一些关键词的与此同时,却常常是越比照,立即就买在了最高点,就和买卖股票一样,每一次总觉得能股票抄底,却不知道买在了浙江天台。因此阿粉想了个方法,把任何的数据拨拉出来,自己做比照,也没去检索了,省的网络平台上一直依据我的搜索内容去开展强烈推荐。

Java怎样做爬虫

大伙儿在想起爬虫的情况下,一定想说,爬虫,这东西并不是学Python的工作人员才可以做的么?大家Java能做呢?阿粉想告知大伙儿的是,可以,Java语言这些年,历经这么多年,怎么可能沒有这种内容呢,因此阿粉就开始了学了 Java 的爬虫路面。

Jsoup

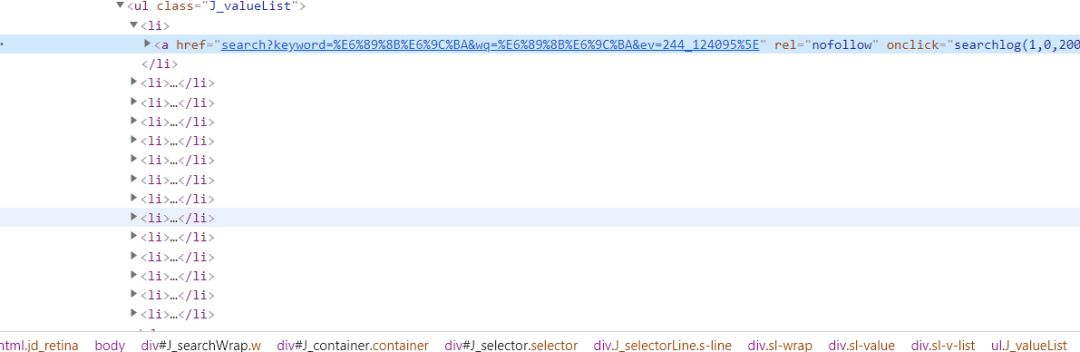

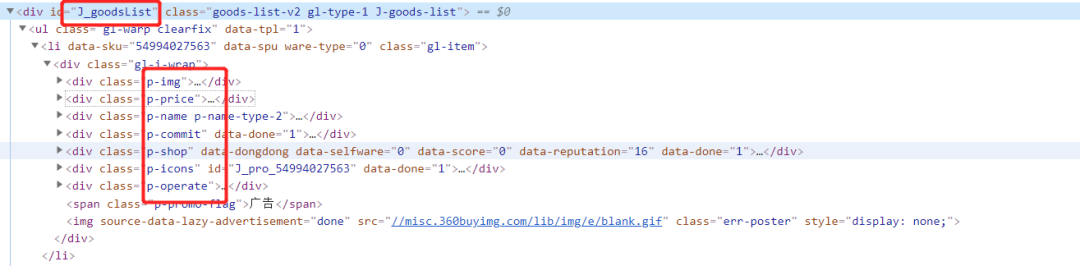

阿粉在详细介绍这一类以前,毫无疑问先得说说大家通常见到的内容是由什么组成的,如今例如大家做开发设计的都了解,最少我们在pc端浏览某东,在某宝平台的数据的情况下,她们给大家意见反馈的数据全是根据 HTML 来开展呈现的,例如这一模样:

在开发设计的一定全是了解,这种全是些是什么意思,阿粉在这儿大家就不会开展详尽的详细介绍,说这一 HTML 到底是个啥东西了,阿粉必须详细介绍的是 Jsoup ,随后告知大伙儿怎么用 Jsoup 这一类抓取京东商城的数据。

正如官方网文本文档所给大家提醒的内容,如何去分析一段 HTML 编码 :

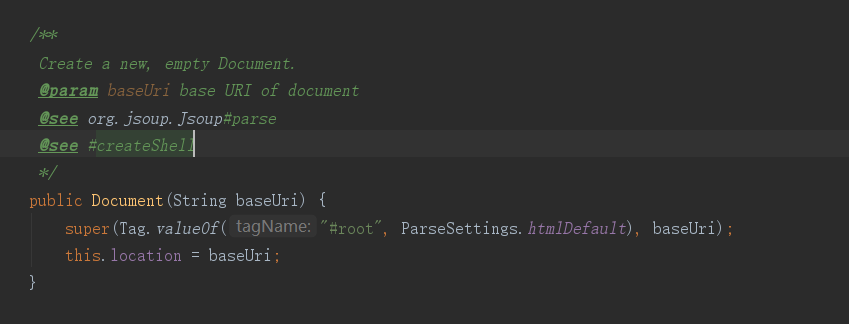

而这一 Document是什么呢?我们可以輸出一下看一眼,顺便着看一下源代码表述,终究嘛,开发者不要看这一类是干什么的,就并不是个达标的程序猿并不是,

輸出内容:

实际上可以看得出这儿,Document事实上是给大家导出了一个新的文本文档,并且是梳理以后的,等同于为以后的剖析 HTML 干了技术专业的提前准备。

而大家在看源代码的注解的情况下,可以看出,Jsoup不单单是能分析大家给的这一字符串数组,还能够是一个URL,还可以是一个文档。

它把大家为他的 HTML 字符串数组转化成了一个目标,这一目标是咱们上边见到的 Document,随后大家就可以成功成章的去应用 Document 目标里边的因素了。

上边是分析字符串数组,那大家看下面这一分析 URL 的存有:

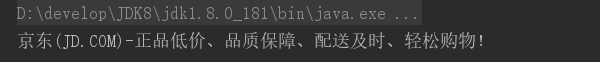

大伙儿实行下列得话,就一定可以见到这一 title 究竟是什么,而效果是这些模样的:

和我们在网页搜索的过程中是否不太一样了,由于这个是进到以后的首页。

Element

而在大家看源代码的情况下,大家能明确的见到,Document 是拥有了 Element 的类,那麼肯定可以启用 Element 里边的方式,例如:

有关方式,阿粉就不会再一一的开展描述了,大伙儿有感兴趣的可以看一看官方网文本文档,或是看一看这一源代码,包名送上 package org.jsoup.nodes

有些人毫无疑问逐渐烦了,说阿粉,你也就别详细介绍了,那你说了过多空话了,赶快详细介绍爬京东商城,好的,这就逐渐,

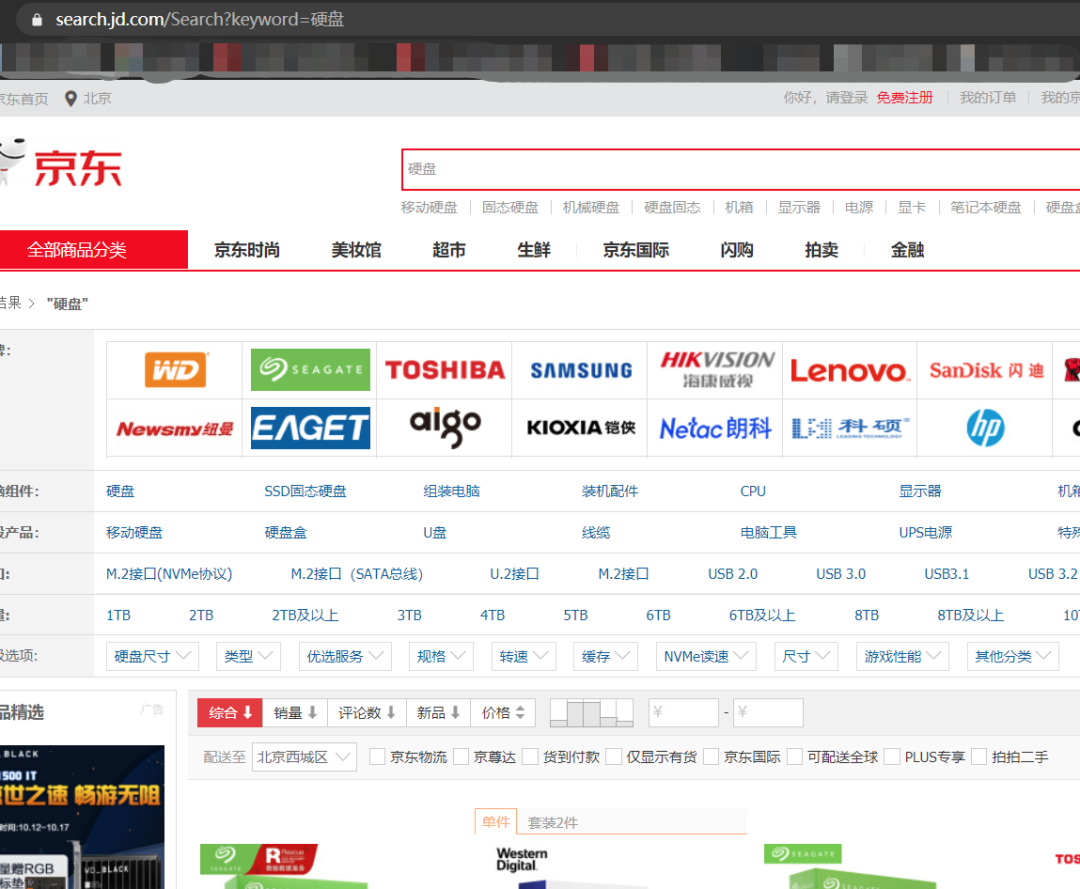

我们在抓取以前毫无疑问先剖析京东商城的网站地址,例如我检索电脑硬盘:

下边就出来一堆数据,而大家则必须解读的也是在 HTML 种最有效的那一部分,例如:

在这儿大家就记录下来了这一价钱,随后大家去找我们要的名称

看,p-name便是大家必须的名称,那麼大家就可以敲代码了。

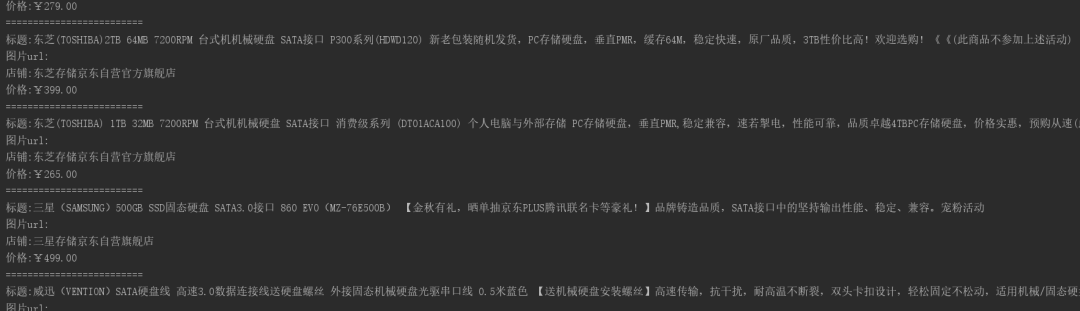

各位看实行的设计效果图:

假如你也有兴趣爱好得话,你能立即在for循环里边新创建一个目标,弄一个List结合,随后在最终的的情况下,实行一下插进数据库查询的方式,那样是否就能详细的把数据信息都保留出来了呢?

写在最终

为何阿粉详细介绍抓取某东,而没去抓取在某宝平台,由于某东是容许你抓取我的数据的,他沒有做所有的反扒体制,而在某宝平台则不好,恰好是应了那一句话

“某东:我卖的是真货,你说我坑人,我赔让你,在某宝平台:我卖假货,可是我并不认可,你能拿我怎么办?某多多的:亲,假一赔十,結果发来11件仿货,”